Pour un référencement facile, pensez robots.txt

Un fichier robots.txt (ou protocole d’exclusion selon Google) indique aux robots d’exploration d’un moteur de recherche les URL auxquelles il peut accéder sur votre site (ou pas). Son objectif principal est d’éviter de surcharger votre site de demandes.

Un fichier robots.txt sert principalement à gérer le trafic des robots d’exploration sur votre site et, généralement, à empêcher Google d’explorer un fichier selon son type :

- Page Web

- Fichier multimédia

- Fichier de ressource

N’utilisez pas de fichier robots.txt pour masquer une de vos pages Web dans les résultats de recherche Google.

Si d’autres pages pointent vers la vôtre avec un texte descriptif, Google peut quand même indexer l’URL sans avoir à accéder à la page elle-même. Si vous voulez empêcher l’affichage de votre page dans les résultats de recherche, utilisez une autre méthode, telle que la protection par mot de passe ou une instruction noindex.

Limites du fichier robots.txt

- Les directives des fichiers robots.txt ne sont pas forcément compatibles avec tous les moteurs de recherche.

Tous robots d’exploration ne sont pas obligés de suivre les instructions des fichiers robots.txt. Nous verrons qu’il est possible de s’adresser à un moteur en particulier si besoin./li> - Les robots d’exploration peuvent interpréter la syntaxe de différentes façons.

Il est important de connaître la syntaxe appropriée (voir ci-dessous), car certains robots pourraient ne pas comprendre certaines instructions. - Une page bloquée par un robot peut tout de même être indexée si elle est référencée sur d’autres sites.

Le contenu bloqué par le fichier robots.txt ne sera ni exploré, ni indexé, mais Google peut toujours trouver et indexer une URL non autorisée si elle est référencée ailleurs sur le Web

Le protocole d’exclusion des robots, plus connu sous le nom de robots.txt, est une convention visant à empêcher les robots d’exploration (web crawlers tels GoogleBot par exemple) d’accéder à tout ou une partie d’un site web. (source : robots.txt).

Vous l’aurez compris, le fichier robots.txt sert plus à empêcher les accès des robots qu’à les autoriser.

Contenu du fichier robots.txt

Le fichier robots.txt doit être placé obligatoirement à la racine de votre site ; si celui-ci est placé dans un répertoire par exemple, les moteurs ne le découvriront pas et ne suivront pas ses règles et paramètres. Par ailleurs, le fichier doit être d’une taille inférieure à 512 Ko.

Le fichier robots.txt est donc un simple fichier texte que nous allons remplir avec des “instructions” pour les moteurs de recherche.

Le fichier robots.txt est constitué d’un ensemble de blocs d’instructions.

Chaque bloc contient deux parties :

- Une ou plusieurs directives User-agent : A quels robots ce bloc s’adresse.

- Une ou plusieurs commandes : Quelles contraintes doivent être respectées.

La commande la plus courante est Disallow, qui permet d’interdire aux robots le crawl d’une portion du site.

Exemple :

# Ce signe en début de ligne indique qu’il s’agit d’un commentaire.

# Début du premier bloc

User-agent: Googlebot

User-agent: Googlebot-News

Disallow: /répertoire 1/

Disallow: /répertoire 2/

# Début du second bloc

User-agent: *

Disallow: /répertoire 3/

# Directive sitemap additionnelle

Sitemap: http://VotreSite.com/sitemap.xml

Voyons maintenant un peu d’explications…

Premier bloc :

On commence par définir les robots auxquels on s’adresse. Dans notre exemple, nous nous adressons à Googlebot —ligne 3— (Googlebot est le nom générique du robot d’exploration de Google. Il désigne deux types de robots d’exploration distincts : l’un simule un internaute sur un ordinateur, tandis que l’autre simule un utilisateur sur un appareil mobile.) et à Googlenot-news —ligne 4— (Il s’agit du robot de Google qui va indexer les “actualités”).

Pour ces 2 robots, on interdit (Disallow) l’accès au /répertoire 1/ —ligne 5— et au /répertoire 2/ —ligne 6—

Deuxième bloc :

Ensuite, pour TOUS les agents (le signe * est un signe générique voulant dire TOUT) —ligne 8—, on interdit l’accès au /répertoire 3/ —ligne 9—

Enfin, afin d’aider Google, nous pouvons spécifier une “directive sitemap” en ligne 11.

Robots.txt : Étude de cas pour un référencement facile

Nous allons étudier le fichier robots.txt du site https://stratosweb.fr.

Il y a plusieurs façons d’accéder au fichier robots.txt suivant votre configuration et votre hébergeur.

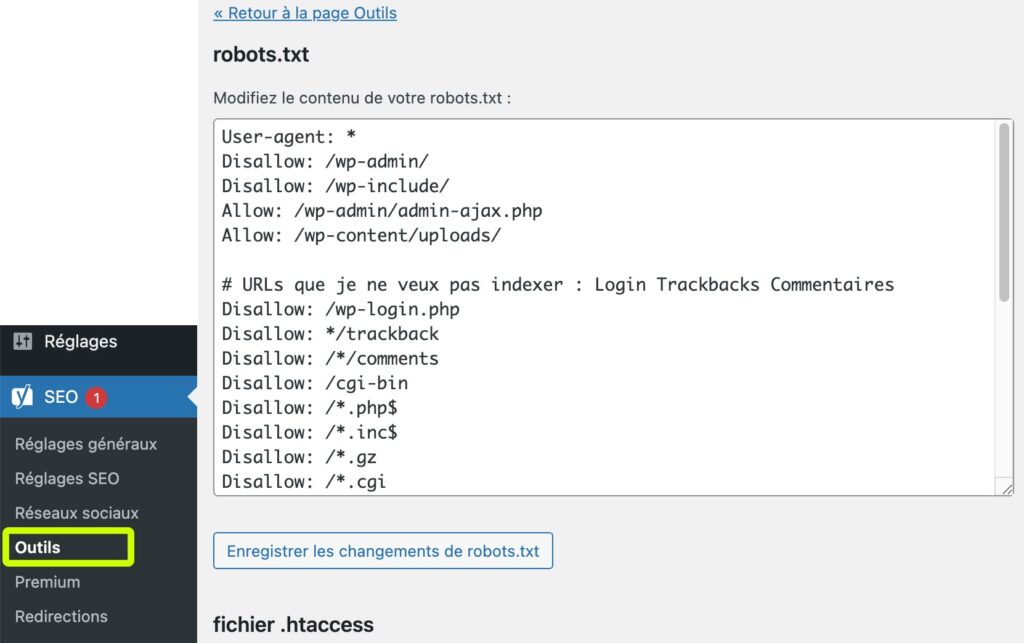

Solution 1 : Plugin WordPress

Si vous êtes sous WordPress, vous aurez déjà probablement installé LE plugin de référencement que je recommande, à savoir YOAST SEO. Dans le menu SEO puis Outils, vous accéderez à une page d’édition de vos fichiers robots.txt et .htaccess (nous en reparlerons dans un prochain article).

Le contenu du fichier robots.txt :

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-include/

Allow: /wp-admin/admin-ajax.php

Allow: /wp-content/uploads/

# URLs que je ne veux pas indexer : Login Trackbacks Commentaires

Disallow: /wp-login.php

Disallow: */trackback

Disallow: /*/comments

Disallow: /cgi-bin

Disallow: /*.php$

Disallow: /*.inc$

Disallow: /*.gz

Disallow: /*.cgi

# URLs autorisées CSS JS Analytics pour les Bots

Allow: /*css?*

Allow: /*js?*

Allow: /*?utm*

Allow: /css/?

# Autoriser Google Image

User-agent: Googlebot-Image

Allow: /*

# Autoriser Google AdSense

User-agent: Mediapartners-Google*

Allow: /*

Sitemap: https://stratosweb.fr/sitemap_index.xml

Explications (par ligne) :

Cette ligne Indique que TOUS les moteurs de recherches sont concernés

interdire l’accès à : /wp-admin/

interdire l’accès à : /wp-include/

autoriser l’accès à : /wp-admin/admin-ajax.php

autoriser l’accès à : /wp-content/uploads/

Le signe # indique un commentaire

interdire l’accès à : /wp-login.php

interdire l’accès à : */trackback

interdire l’accès à : /*/comments

interdire l’accès à : /cgi-bin

interdire l’accès à : /*.php$

interdire l’accès à : /*.inc$

interdire l’accès à : /*.gz

interdire l’accès à : /*.cgi

# URLs autorisées CSS JS Analytics pour les Robots

autoriser l’accès à : /*css?*

autoriser l’accès à : /*js?*

autoriser l’accès à : /*?utm*

autoriser l’accès à : /css/?

# Autoriser Google Image : ce qui suit permet à accès total au moteur d’images de Google

User-agent: Googlebot-Image

Allow: /*

# Autoriser Google AdSense : ce qui suit permet à accès total aux partenaires médias de Google

User-agent: Mediapartners-Google*

Allow: /*

# la dernière ligne est là pour aider Google a repérer le fichier sitemap

Sitemap: https://stratosweb.fr/sitemap_index.xml

Chaque fichier robots.txt peut être personnalisé à l’envie en fonction de ce que désirez que les moteurs de recherches voient… ou ne voient pas. Ainsi par exemples, si vous ne désirez pas que vos images soient visibles et indexées par un moteur de recherches d’images de Google, il suffit de changer les lignes :

User-agent: Googlebot-Image

Allow: /*

en :

User-agent: Googlebot-Image

Disallow: /*

Allow : Autoriser — Disallow : interdire

ATTENTION : les instructions que vous donnez au fichier robots.txt ne sert pas à désindexer du contenu, mais a empêcher qu’il ne soit parcouru. Ainsi, si la page n’avait jamais été indexée avant, empêcher son crawl permettra de ne jamais l’indexer, en revanche si la page est déjà indexée ou si un autre site du web lui fait un lien, le robots.txt ne permettra pas de la désindexer.

L’objectif principal du fichier robots.txt est donc de manager le temps de crawl du robot en lui interdisant de parcourir des pages à faible valeur ajoutée, mais qui doivent exister pour le parcours utilisateur (panier d’achat, etc).

PS : le fichier robots.txt est l’un des premiers fichiers analysés par les moteurs.

De plus, tous les robots ne respectent pas forcément les instructions de votre fichier robots.txt.

Pourquoi un fichier robots.txt pour un référencement facile ?

Les cas d’utilisation courants incluent :

- Éviter l’exploration de contenu dupliqué.

- Éviter l’exploration d’un moteur de recherche interne.

- Empêcher les moteurs de recherche d’indexer certaines images de votre site.

- Spécifier l’emplacement du plan de site.

- Spécification d’un délai d’analyse afin d’éviter que vos serveurs ne soient surchargés lorsque les robots d’exploration chargent simultanément plusieurs éléments de contenu.

Si votre site ne contient aucune zone sur laquelle vous souhaitez contrôler l’accès des utilisateurs, il se peut que vous n’ayez pas besoin d’un fichier robots.txt.

Voici des exemples de page à ne pas indexer

- Des pages dont le contenu n’est pas intéressant ou que l’on souhaite cacher comme par exemple ses mentions légales, une page de remerciement après avoir rentré son adresse e-mail pour s’inscrire à la newsletter du site web…

- Éviter le contenu dupliqué entre certaines pages. Par exemple la version imprimable de son site

- Ne pas vouloir indexer des fichiers PDF qui auraient le même contenu que les pages de votre site

- Ne pas vouloir indexer des images dans Google image

- Des pages avec un contenu de faible qualité

- Des pages non visitées depuis longtemps (dont le trafic provient des moteurs de recherche)

- Des fichiers de construction du site web comme avec WordPress par exemple.

Conclusion

Le robots.txt permet d’exclure l’accès aux robots sur certaines parties de vos pages web, notamment si une zone de votre page est privé ou si le contenu n’est pas indispensable pour les moteurs de recherche. Ainsi, le robots.txt est un outil indispensable pour maîtriser l’indexation de ses pages.

Views: 218